NVIDIA là thương hiệu hàng đầu trong việc sản xuất GPU (Chip xử lý đồ họa). Họ luôn đưa ra những sản phẩm mang tính chất đột phá. Tiêu biểu là kiến trúc GPU Turing. Vậy NVIDIA Turing là gì? Những ưu điểm nổi bật của kiến trúc GPU này so với thế hệ trước Pascal ra sao, hãy cùng bài viế tìm hiểu nhé.

Kiến trúc Turing là gì?

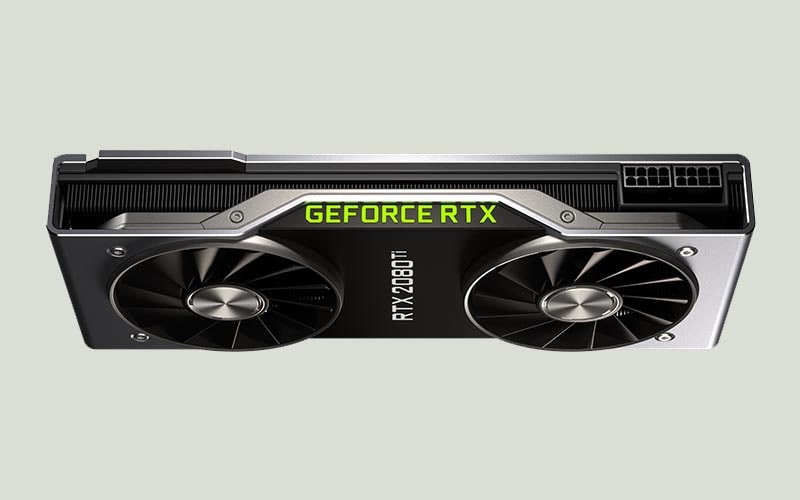

Turing là một kiến trúc đồ họa được phát triển bởi NVIDIA. Được giới thiệu lần đầu vào năm 2018, kiến trúc này được sử dụng trong các dòng card đồ họa NVIDIA GeForce RTX và Quadro RTX.

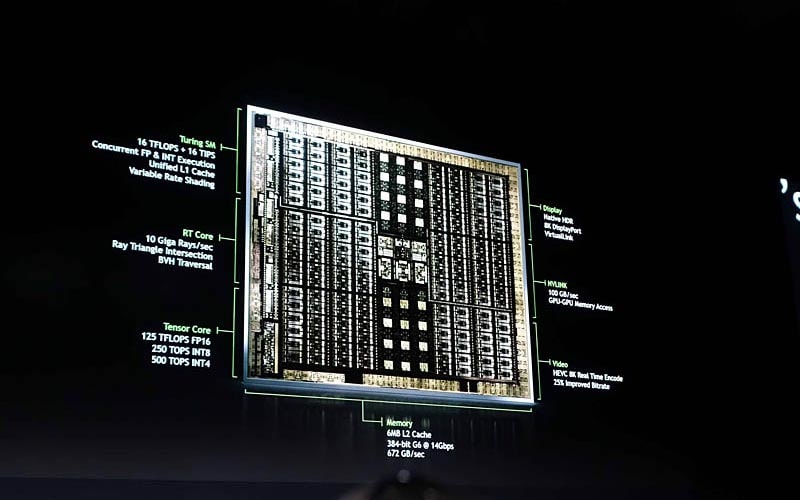

Kiến trúc Turing có nhiều cải tiến so với các phiên bản trước đó, đặc biệt là trong việc xử lý ray tracing thời gian thực. Kiến trúc này sử dụng các nhân xử lý Tensor và RT Core để tăng cường hiệu suất ray tracing.

Ngoài ra, kiến trúc Turing cũng cải thiện hiệu suất xử lý đồ họa thông thường. Nó có một số tính năng như CUDA Cores, Tensor Cores và ROPs (Raster Operations Pipelines) để tăng cường khả năng xử lý đồ họa và tính toán. Turing cũng hỗ trợ công nghệ DLSS (Deep Learning Super Sampling), cho phép tăng độ phân giải và chất lượng hình ảnh mà không ảnh hưởng đến hiệu suất.

Nó cũng hỗ trợ công nghệ GDDR6, cung cấp băng thông cao hơn và tốc độ truyền dữ liệu nhanh hơn. Nhìn chung, kiến trúc Turing là một bước tiến lớn trong công nghệ đồ họa, mang lại hiệu suất và chất lượng hình ảnh tốt hơn cho người dùng.

Những ưu điểm của NVIDIA Turing

- Hiệu suất cao: Kiến trúc GPU Turing được thiết kế để cung cấp hiệu suất đồ họa và tính toán tốt hơn so với các phiên bản trước đó. Với sự cải tiến về hiệu năng và khả năng xử lý song song, GPU Turing có thể xử lý một lượng lớn công việc đồ họa và tính toán một cách nhanh chóng và hiệu quả.

- Ray Tracing: Một trong những tính năng nổi bật của kiến trúc GPU Turing là khả năng hỗ trợ công nghệ ray tracing thời gian thực. Ray tracing là một phương pháp tính toán ánh sáng chân thực, giúp tạo ra hình ảnh đồ họa có chất lượng cao với ánh sáng, bóng đổ và phản xạ tự nhiên hơn. GPU Turing có các nhân xử lý ray tracing (RT Cores) được tối ưu hóa để xử lý các phép tính ray tracing một cách hiệu quả.

- Deep Learning: GPU Turing cũng được tối ưu hóa cho các ứng dụng deep learning và AI. Với các nhân Tensor (Tensor Cores), GPU Turing có khả năng xử lý các phép tính tensor nhanh chóng và hiệu quả, giúp tăng tốc quá trình huấn luyện và triển khai mô hình deep learning.

- GDDR6 Memory: GPU Turing hỗ trợ việc sử dụng bộ nhớ GDDR6, đây là một loại bộ nhớ nhanh và có băng thông cao, giúp tăng tốc quá trình truyền dữ giữa GPU và bộ nhớ.

- Tích hợp công nghệ mới: Kiến trúc GPU Turing cung cấp các tínhnh năng và công nghệ mới như Variable Rate Shading (VRS), Mesh Shading và Texture-Space Shading, giúp cải thiện hiệu suất đồ họa và tăng cường khả năng hiển thị hình ảnh.

Nhược điểm của kiến trúc Turing

- Giá thành cao: GPU Turing thường có giá thành cao hơn so với các phiên bản trước đó, do tính năng và hiệu suất nâng cao.

- Tiêu thụ năng lượng: Kiến trúc Turing có xu hướng tiêu thụ năng lượng cao hơn so với các phiên bản trước đó, đặc biệt khi hoạt động ở tải công việc nặng.

- Hạn chế về tương thích: Một số ứng dụng và trò chơi có thể không tối ưu hoá hoặc không tương thích tốt với kiến trúc GPU Turing, đặc biệt là trong giai đoạn đầu sau khi ra mắt.

- Kích thước và cấu trúc: GPU Turing có kích thước lớn hơn so với các phiên bản trước đó, điều này có thể gây khó khăn trong việc lắp đặt vào các hệ thống máy tính nhỏ gọn hoặc có không gian hạn chế.

- Hỗ trợ phần mềm: Một số phần mềm và trình điều khiển có thể cần được cập nhật để tương thích tốt với kiến trúc GPU Turing, và việc này có thể gây khó khăn cho người dùng.

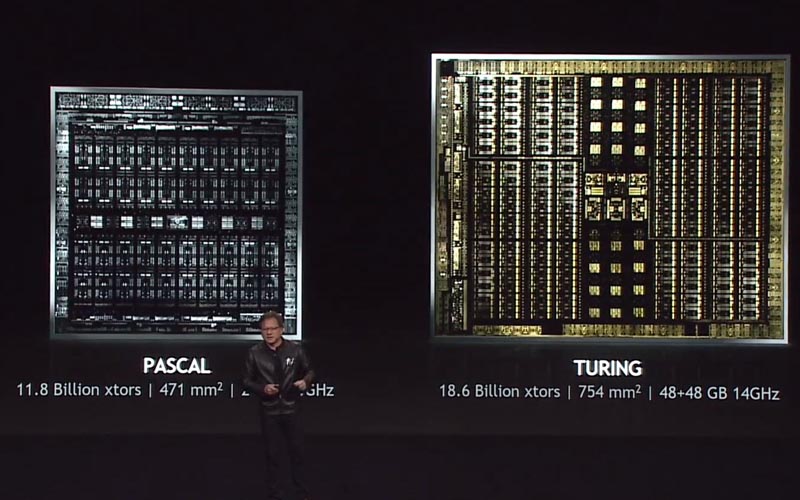

So sánh kiến trúc Turing vs Pascal

- Hiệu suất: Kiến trúc Turing có hiệu suất cao hơn so với Pascal. Với việc sử dụng các công nghệ tiên tiến như Tensor Cores và RT Cores, Turing có khả năng xử lý AI và đồ họa thời gian thực tốt hơn.

- Ray Tracing: Turing là thế hệ đầu tiên hỗ trợ công nghệ Ray Tracing thời gian thực, cho phép tạo ra hình ảnh chân thực hơn với ánh sáng và bóng đổ tự nhiên. Pascal không có tính năng này.

- AI và Deep Learning: Turing được cải tiến để tối ưu hóa cho các ứng dụng AI và Deep Learning. Với Tensor Cores, Turing có khả năng xử lý dữ liệu AI nhanh hơn và hiệu quả hơn so với Pascal.

- Tiêu thụ năng lượng: Pascal tiêu thụ ít năng lượng hơn so với Turing. Turing có nhiều tính năng tiên tiến hơn, nhưng điều này cũng đồng nghĩa với việc tiêu thụ năng lượng cao hơn.

- Giá thành: Pascal đã có một thời gian dài trên thị trường và giá thành của nó đã giảm đi đáng kể. Turing, với các tính năng mới và hiệu suất cao hơn, có giá thành cao hơn.

Về cơ bản, Turing là một bước tiến lớn so với Pascal với hiệu suất cao hơn, hỗ trợ Ray Tracing và AI tốt hơn. Tuy nhiên, Pascal vẫn là một lựa chọn tốt với giá thành thấp hơn và tiêu thụ năng lượng ít hơn.

Danh sách các Card đồ họa sử dụng kiến trúc Turning

| GPU Name | Codename | Release Date |

|---|---|---|

| Nvidia GeForce GTX 1630 | Nvidia TU117 | 06/2022 |

| Nvidia GeForce GTX 1650 (GDDR5) | Nvidia TU117 | 04/2019 |

| Nvidia GeForce GTX 1650 (TU106) | Nvidia TU106 | 06/2020 |

| Nvidia GeForce GTX 1650 (TU116) | Nvidia TU116 | 07/2020 |

| Nvidia GeForce GTX 1650 (TU117) | Nvidia TU117 | 04/2020 |

| Nvidia GeForce GTX 1650 Super | Nvidia TU116 | 11/2019 |

| Nvidia GeForce GTX 1660 | Nvidia TU116 | 03/2019 |

| Nvidia GeForce GTX 1660 Super | Nvidia TU116 | 10/2019 |

| Nvidia GeForce GTX 1660 Ti | Nvidia TU116 | 02/2019 |

| Nvidia GeForce RTX 2060 (12 GB) | Nvidia TU106 | 12/2021 |

| Nvidia GeForce RTX 2060 (6 GB) (TU104) | Nvidia TU104 | 01/2020 |

| Nvidia GeForce RTX 2060 (6 GB) (TU106) | Nvidia TU106 | 01/2019 |

| Nvidia GeForce RTX 2060 Super | Nvidia TU106 | 07/2019 |

| Nvidia GeForce RTX 2070 (TU106-400) | Nvidia TU106 | 10/2018 |

| Nvidia GeForce RTX 2070 (TU106-400A) | Nvidia TU106 | 10/2018 |

| Nvidia GeForce RTX 2070 Super | Nvidia TU104 | 07/2019 |

| Nvidia GeForce RTX 2080 (TU104-400) | Nvidia TU104 | 09/2018 |

| Nvidia GeForce RTX 2080 (TU104-400A) | Nvidia TU104 | 09/2018 |

| Nvidia GeForce RTX 2080 Super | Nvidia TU104 | 07/2019 |

| Nvidia GeForce RTX 2080 Ti (TU102-300) | Nvidia TU102 | 09/2018 |

| Nvidia GeForce RTX 2080 Ti (TU102-300A) | Nvidia TU102 | 09/2018 |

| Nvidia Titan RTX | Nvidia TU102 | 12/2018 |