Khi tìm hiểu về Card màn hình rời máy tính (VGA), chắc hẳn bạn đã bắt gặp thuật ngữ CUDA. Vậy đây là thành phần gì và đóng vai trò như thế nào đối với VGA. Tại sao hiệu năng Card đồ họa rời lại được đánh giá qua số lượng nhân CUDA, hãy cùng bài viết tìm hiểu nhé.

CUDA là gì?

CUDA (Compute Unified Device Architecture) là một nền tảng tính toán song song được phát triển bởi NVIDIA. Nó cho phép các nhà phát triển sử dụng GPU (Graphics Processing Unit) của NVIDIA để thực hiện các tác vụ tính toán song song, không chỉ giới hạn trong lĩnh vực đồ họa mà còn trong các lĩnh vực khác như khoa học, máy học, và tính toán số.

CUDA cung cấp một bộ công cụ và API cho việc lập trình GPU, cho phép tận dụng sức mạnh tính toán song song của GPU để tăng tốc độ xử lý và hiệu suất tính toán.

Ứng dụng của CUDA

CUDA có nhiều ứng dụng trong lĩnh vực tính toán song song và xử lý dữ liệu trên GPU. Dưới đây là một số ứng dụng phổ biến của CUDA:

- Tính toán khoa học và tính toán số học: CUDA cho phép các nhà nghiên cứu và kỹ sư sử dụng GPU để tăng tốc độ tính toán trong các lĩnh vực như mô phỏng vật lý, phân tích dữ liệu, machine learning và trí tuệ nhân tạo.

- Xử lý hình ảnh và video: CUDA được sử dụng để tăng tốc độ xử lý hình ảnh và video, bao gồm các công việc như xử lý ảnh, nhận dạng khuôn mặt, phân tích video và nén video.

- Machine Learning & Deep Learning: CUDA cung cấp khả năng tính toán mạnh mẽ cho các thuật toán học máy và học sâu, giúp tăng tốc quá trình huấn luyện và dự đoán mô hình.

- Mô phỏng và mô hình hóa: CUDA được sử dụng để tạo ra các mô phỏng và mô hình hóa trong các lĩnh vực như địa chất, khí tượng học, sinh học và vật lý.

- Xử lý dữ liệu lớn: CUDA cho phép xử lý dữ liệu lớn và phân tán trên nhiều GPU, giúp tăng tốc độ xử lý và hiệu suất của các ứng dụng dữ liệu lớn.

- Công nghệ đồ họa và trò chơi: CUDA được sử dụng để tăng cường hiệu suất đồ họa và xử lý hình ảnh trong các ứng dụng đồ họa và trò chơi.

- Mật mã hóa và bảo mật: CUDA cung cấp khả năng tính toán mạnh mẽ cho các thuật toán mã hóa và bảo mật, giúp tăng cường bảo mật dữ liệu và thông tin.

Nhân CUDA (CUDA Cores) là gì?

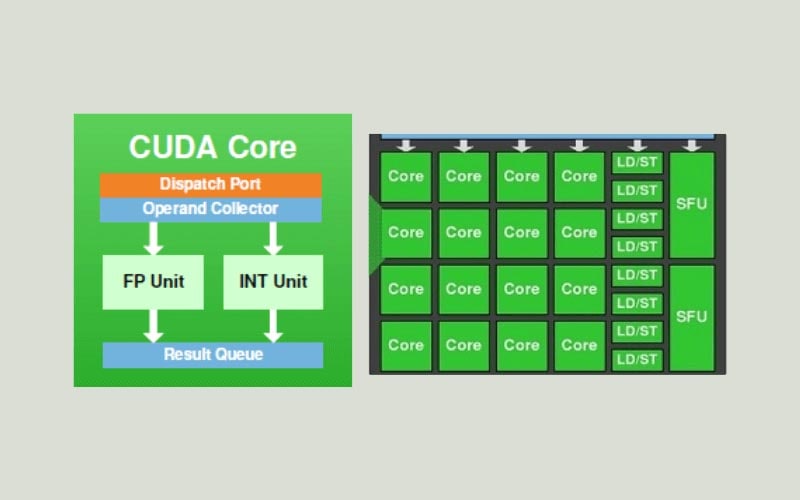

Nhân CUDA (CUDA cores) là các đơn vị tính toán trong GPU (Graphics Processing Unit) của NVIDIA. Mỗi nhân CUDA có khả năng thực hiện các phép tính đồng thời và độc lập, giúp tăng hiệu suất tính toán song song trên GPU.

Số lượng nhân CUDA trên một GPU thường được xem là một chỉ số quan trọng để đánh giá khả năng tính toán của GPU đó. Mỗi thế hệ GPU của NVIDIA có số lượng nhân CUDA khác nhau, và việc có nhiều nhân CUDA hơn thường cho phép thực hiện các tác vụ tính toán phức tạp nhanh hơn.

Vai trò của nhân CUDA trong Card đồ họa NVIDIA

Nhân CUDA trên card đồ họa NVIDIA có vai trò chính là thực hiện tính toán song song và xử lý dữ liệu trên GPU (Graphics Processing Unit).

Các nhân CUDA được thiết kế để thực hiện các tác vụ tính toán phức tạp và đa luồng, giúp tăng tốc độ xử lý và hiệu suất của card đồ họa. Dưới đây là một số vai trò chính của nhân CUDA trên card đồ họa NVIDIA bao gồm:

- Xử lý đồ họa: Nhân CUDA giúp xử lý các tác vụ đồ họa phức tạp như render hình ảnh, tạo hiệu ứng đặc biệt, xử lý ánh sáng và màu sắc,… Nhờ vào tính toán song song và khả năng xử lý đa luồng, nhân CUDA giúp tăng cường hiệu suất xử lý đồ họa trên card đồ họa NVIDIA.

- Tính toán khoa học và học máy: Nhân CUDA cung cấp một môi trường tính toán mạnh mẽ cho các ứng dụng khoa học và học máy. Các nhân CUDA có khả năng thực hiện các ph phép tính phức tạp và đa luồng, giúp tăng tốc độ tính toán và hiệu suất của các thuật toán khoa học và học máy.

- Xử lý video và âm thanh: Nhân CUDA hỗ trợ xử lý video và âm thanh trên card đồ họa NVIDIA. Các tác vụ như mã hóa, giải mã, xử lý và phân tích video và âm thanh có thể được thực hiện nhanh chóng và hiệu quả hơn nhờ vào tính toán song song và khả năng xử lý đa luồng của nhân CUDA.

- Tính toán song song và đa luồng: Nhân CUDA cung cấp khả năng tính toán song song và đa luồng, cho phép thực hiện nhiều tác vụ cùng một lúc trên card đồ họa NVIDIA. Điều này giúp tăng tốc độ xử lý và hiệu suất của các ứng dụng sử dụng card đồ họa NVIDIA.

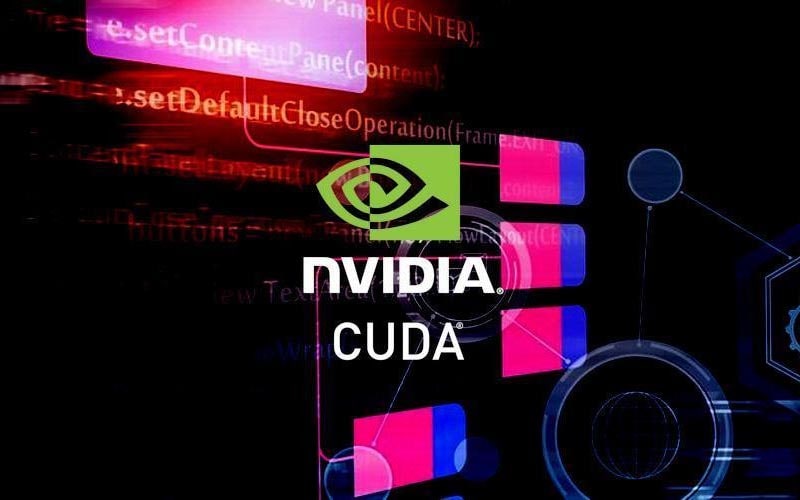

Số nhân CUDA có trên Card đồ họa NVIDIA qua từng thế hệ

| NVIDIA Card 4000 Series | Number of CUDA Cores | Size of Power Supply | Memory Type | Memory Interface Width | Memory Bandwidth GB/sec | Base Clock Speed | Boost Clock Speed | NOTES |

| RTX-4080 | 9728 | 750 watt | GDDR6X | 256 bit | 716.8 GB/s | 2.21 GHz | 2.51 GHz | 16 GB of Memory |

| RTX-4090 | 16384 | 850 watt | GDDR6X | 384 bit | 1008 GB/s | 2.23 GHz | 2.52 GHz | 24 GB of Memory |

| NVIDIA Card 3000 Series | Number of CUDA Cores | Size of Power Supply | Memory Type | Memory Interface Width | Memory Bandwidth GB/sec | Base Clock Speed | Boost Clock Speed | NOTES |

| RTX-3050 | 2560 | 550 watt | GDDR6 | 128 bit | 224 GB/s | 1550 MHz | 1780 MHz | Standard with 8 GB of Memory |

| RTX-3060 | 3584 | 550 watt | GDDR6 | 192 bit | 384 GB/s | 1320 MHz | 1780 MHz | Standard with 12 GB of Memory |

| RTX-3060 Ti | 4864 | 600 watt | GDDR6 | 256 bit | 448 GB/s | 1410 MHz | 1670 MHz | Standard with 8 GB of Memory |

| RTX-3070 | 5888 | 650 watt | GDDR6 | 256 bit | 448 GB/s | 1580 MHz | 1770 MHz | Standard with 8 GB of Memory |

| RTX-3070 Ti | 6144 | 750 watt | GDDR6X | 256 bit | 608 GB/s | 1500 MHz | 1730 MHz | Standard with 8 GB of Memory |

| RTX-3080 | 8704 | 750 watt | GDDR6X | 320 bit | 760 GB/s | 1440 MHz | 1710 MHz | Standard with 10 GB of Memory |

| RTX-3080 Ti | 10240 | 750 watt | GDDR6X | 384 bit | 912 GB/s | 1370 MHz | 1670 MHz | Standard with 12 GB of Memory |

| RTX-3090 | 10496 | 750 watt | GDDR6X | 384 bit | 936 GB/s | 1400 MHz | 1700 MHz | Standard with 24 GB of Memory |

| RTX-3090 Ti | 10572 | 850 watt | GDDR6X | 384 bit | 936 GB/s | 1670 MHz | 1860 MHz | Standard with 24 GB of Memory |

| NVIDIA Card 2000 Series | Number of CUDA Cores | Size of Power Supply | Memory Type | Memory Interface Width | Memory Bandwidth GB/sec | Base Clock Speed | Boost Clock Speed | NOTES |

| RTX-2060 | 1920 | 500 watt | GDDR6 | 192 bit | 336 GB/s | 1365 MHz | 1680 MHz | Standard with 6 GB of Memory |

| RTX-2060 Super | 2176 | 550 watt | GDDR6 | 256 bit | 448 GB/s | 1470 MHz | 1650 MHz | Standard with 8 GB of Memory |

| RTX-2070 | 2304 | 550 watt | GDDR6 | 256 bit | 448 GB/s | 1410 MHz | 1620 MHz | Standard with 8 GB of Memory |

| RTX-2070 Super | 2560 | 650 watt | GDDR6 | 256 bit | 448 GB/s | 1605 MHz | 1770 MHz | Standard with 8 GB of Memory |

| RTX-2080 | 2944 | 650 watt | GDDR6 | 256 bit | 448 GB/s | 1515 MHz | 1710 MHz | Standard with 8 GB of Memory |

| RTX-2080 Super | 3072 | 650 watt | GDDR6 | 256 bit | 496 GB/s | 1650 MHz | 1815 MHz | Standard with 8 GB of Memory |

| RTX-2080 Ti | 4352 | 650 watt | GDDR6 | 352 bit | 616 GB/s | 1350 MHz | 1545 MHz | Standard with 11 GB of Memory |

| Titan RTX | 4608 | 650 watt | GDDR6 | 384 bit | 672 GB/s | 1350 MHz | 1770 MHz | Standard with 24 GB of Memory |

| NVIDIA Card 1600 Series | Number of CUDA Cores | Size of Power Supply | Memory Type | Memory Interface Width | Memory Bandwidth GB/sec | Base Clock Speed | Boost Clock Speed | NOTES |

| GTX-1650 | 896 | 300 watt | GDDR5 | 128 bit | 128 GB/s | 1485 MHz | 1665 MHz | Standard with 4 GB of Memory |

| GTX-1650 Super | 1280 | 350 watt | GDDR6 | 128 bit | 192 GB/s | 1530 MHz | 1725 MHz | Standard with 4 GB of Memory |

| GTX-1660 | 1408 | 450 watt | GDDR5 | 192 bit | 192 GB/s | 1530 MHz | 1785 MHz | Standard with 6 GB of Memory |

| GTX-1660 Super | 1408 | 450 watt | GDDR6 | 192 bit | 336 GB/s | 1530 MHz | 1785 MHz | Standard with 6 GB of Memory |

| GTX-1660 Ti | 1536 | 450 watt | GDDR6 | 192 bit | 288 GB/s | 1500 MHz | 1770 MHz | Standard with 6 GB of Memory |

| NVIDIA Card 1000 Series | Number of CUDA Cores | Size of Power Supply | Memory Type | Memory Interface Width | Memory Bandwidth GB/sec | Base Clock Speed | Boost Clock Speed | NOTES |

| GTX-1010 | 384 | 200 watt | GDDR5 | 64 bit | 41.1 GB/s | 1228 MHz | 1468 MHz | Standard with 2 GB of Memory |

| GTX-1030 | 384 | 300 watt | GDDR5 | 64 bit | 48 GB/s | 1277 MHz | 1468 MHz | Standard with 2 GB of Memory |

| GTX-1050 2GB | 640 | 300 watt | GDDR5 | 128 bit | 112 GB/s | 1354 MHz | 1455 MHz | Standard with 2 GB of Memory |

| GTX-1050 3GB | 768 | 300 watt | GDDR5 | 96 bit | 84 GB/s | 1392 MHz | 1518 MHz | Standard with 3 GB of Memory |

| GTX-1050 Ti | 768 | 300 watt | GDDR5 | 128 bit | 112 GB/s | 1290 MHz | 1392 MHz | Standard with 4 GB of Memory |

| GTX-1060 3GB | 1152 | 400 watt | GDDR5 | 192 bit | 192 GB/s | 1506 MHz | 1708 MHz | Standard with 3 GB of Memory |

| GTX-1060 6GB | 1280 | 400 watt | GDDR5 | 192 bit | 192 GB/s | 1506 MHz | 1708 MHz | Standard with 6 GB of Memory |

| GTX-1070 | 1920 | 500 watt | GDDR5 | 256 bit | 256 GB/s | 1506 MHz | 1683 MHz | Standard with 8 GB of Memory |

| GTX-1070 Ti | 2432 | 500 watt | GDDR5 | 256 bit | 256 GB/s | 1607 MHz | 1683 MHz | Standard with 8 GB of Memory |

| GTX-1080 | 2560 | 500 watt | GDDR5 | 256 bit | 320 GB/s | 1607 MHz | 1733 MHz | Standard with 8 GB of Memory |

| GTX-1080 Ti | 3584 | 600 watt | GDDR5X | 352 bit | 484 GB/s | 1480 MHz | 1582 MHz | Standard with 11 GB of Memory |

So sánh CUDA Core vs Stream Processor

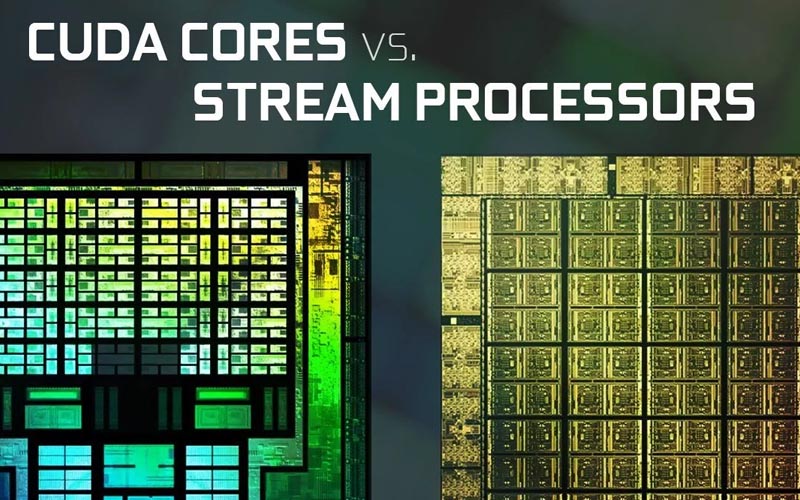

Stream processor và CUDA core là hai thuật ngữ được sử dụng để chỉ các đơn vị xử lý trong các kiến trúc đồ họa khác nhau.

Stream Processor

Đây là thuật ngữ được sử dụng trong kiến trúc đồ họa AMD (trước đây là ATI). Nó là một đơn vị xử lý đa năng có thể thực hiện nhiều loại tính toán, bao gồm cả tính toán đồ họa và tính toán chung. Stream processor thường được sử dụng trong các card đồ họa AMD Radeon.

CUDA Core

Đây là thuật ngữ được sử dụng trong kiến trúc đồ họa NVIDIA. Nó là một đơn vị xử lý chuyên dụng được thiết kế đặc biệt để thực hiện tính toán song song trong các ứng dụng sử dụng CUDA (Compute Unified Device Architecture). CUDA core thường được sử dụng trong các card đồ họa NVIDIA GeForce và Quadro.

Dưới đây là một số điểm tương đồng và khác biệt giữa stream processor và CUDA core:

Tương đồng:

- Cả stream processor và CUDA core đều là các đơn vị xử lý trong kiến trúc đồ họa.

- Cả hai đều có khả năng thực hiện tính toán song song và xử lý dữ liệu đồ họa.

Khác biệt:

- Stream processor là thuật ngữ được sử dụng trong kiến trúc đồ họa AMD, trong khi CUDA core là thuật ngữ được sử dụng trong kiến trúc đồ họa NVIDIA.

- Stream processor có thể thực hiện nhiều loại tính toán, trong khi CUDA core được thiết kế đặc biệt để thực hiện tính toán song song trong các ứng dụng sử dụng CUDA.

- Số lượng stream processor và CUDA core có thể khác nhau giữa các card đồ họa khác nhau và cũng phụ thuộc vào thế hệ và mô hình của card đồ họa.

Các câu hỏi thường gặp

Số nhân CUDA ảnh hưởng tới gaming như thế nào?

Số lượng nhân CUDA trên card đồ họa có thể ảnh hưởng đến hiệu suất gaming. Nhân CUDA là các đơn vị xử lý song song trên card đồ họa NVIDIA, được sử dụng để thực hiện các phép tính đồ họa và tính toán song song.

Khi chơi game, các phép tính đồ họa như shading, lighting, texture mapping và physics simulation đòi hỏi sự tính toán song song để xử lý nhanh chóng và hiệu quả. Số lượng nhân CUDA càng nhiều, card đồ họa có khả năng xử lý đồ họa và tính toán song song càng tốt, giúp tăng hiệu suất và độ mượt của game.

Tuy nhiên, số lượng nhân CUDA không phải là yếu tố duy nhất quyết định hiệu suất gaming. Các yếu tố khác như tốc độ xung nhịp, băng thông bộ nhớ, kiến trúc GPU và tối ưu hóa phần mềm cũng đóng vai trò quan trọng.

Do đó, việc so sánh hiệu suất giữa các card đồ họa không chỉ dựa trên số lượng nhân CUDA mà còn phải xem xét tổng thể các yếu tố kỹ thuật khác.

Càng nhiều nhân CUDA càng tốt?

Đúng, càng nhiều nhân CUDA trên card đồ họa thì càng tốt cho hiệu suất gaming.

Nhân CUDA là các đơn vị xử lý song song trên card đồ họa NVIDIA, và chúng đóng vai trò quan trọng trong việc thực hiện các phép tính đồ họa và tính toán song song. Khi chơi game, các phép tính đồ họa phải được xử lý nhanh chóng và hiệu quả để đảm bảo mượt mà và chất lượng hình ảnh.

Số lượng nhân CUDA càng nhiều, card đồ họa có khả năng xử lý đồ họa và tính toán song song càng cao, giúp tăng cường hiệu suất và đáp ứng được các yêu cầu đồ họa phức tạp của các trò chơi hiện đại.

Tuy nhiên, cần lưu ý rằng hiệu suất gaming không chỉ phụ thuộc vào số lượng nhân CUDA mà còn phụ thuộc vào nhiều yếu tố khác như tốc độ xung nhịp, bộ nhớ, kiến trúc và tối ưu hóa phần mềm.

Do đó, khi chọn card đồ họa cho gaming, cần xem xét tổng thể các yếu tố kỹ thuật và đáp ứng được yêu cầu của trò chơi mà bạn muốn chơi.

CUDNN là gì?

CUDNN (CUDA Deep Neural Network) là một thư viện phần mềm được phát triển bởi NVIDIA, được thiết kế để tối ưu hóa việc huấn luyện và triển khai các mạng neural sử dụng GPU.

CUDNN cung cấp các hàm và thuật toán tối ưu hóa để tăng tốc độ tính toán trên GPU, đồng thời giảm thời gian huấn luyện và triển khai mạng neural. Nó được sử dụng rộng rãi trong lĩnh vực trí tuệ nhân tạo và học sâu để tăng cường hiệu suất và tốc độ tính toán trên GPU.